ChatGPT liefert perfekt formulierte Antworten, die jedoch nicht immer korrekt sind. Japanische Forscher fanden Parallelen zur Aphasie, einer Sprachstörung, bei der die Sprache flüssig klingt, aber oft bedeutungslos ist.

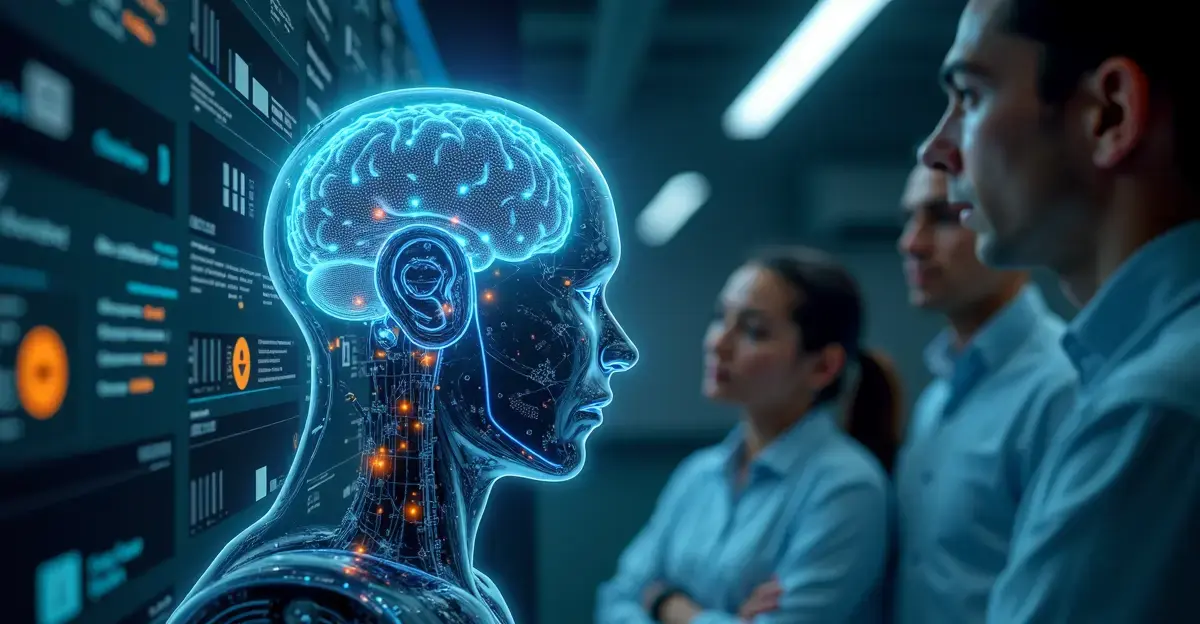

Mithilfe einer Energielandschaftsanalyse verglich das Team Hirnaktivitätsmuster bei Aphasiepatienten mit internen Daten großer Sprachmodelle (LLMs). Sie entdeckten auffällige Ähnlichkeiten in der Informationsverarbeitung, was darauf hindeutet, dass KI-Modelle, ähnlich wie Menschen mit Aphasie, in starren Mustern feststecken können, die den Zugang zu breiterem Wissen einschränken.

Die Ergebnisse könnten helfen, die KI-Architektur zu verbessern und sogar als Biomarker für neurologische Erkrankungen dienen.

Nederlands

Nederlands

English

English

Deutsch

Deutsch

Français

Français

Español

Español

Português

Português