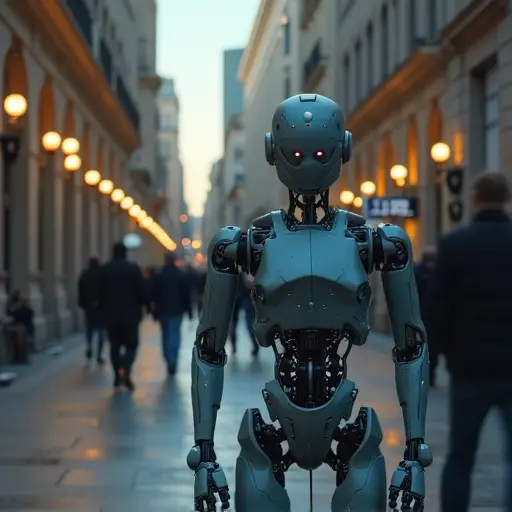

KI-Unternehmen können sich nicht auf die Meinungsfreiheit berufen, wenn ihre KI-Chatbots schädliche Aussagen tätigen. Ein US-Richter entschied dies in einem Rechtsstreit über den Suizid eines 14-jährigen Jungen.

Die Klage wurde gegen Character.Ai eingereicht, ein Unternehmen, das Rollenspiele mit Chatbots ermöglicht. Der Fall dreht sich um den 14-jährigen Sewell Setzer III, der wochenlang mit einem Bot sprach, der sich als Dany aus Game of Thrones ausgab. Er wurde emotional abhängig vom Chatbot und verlor den Realitätssinn. 'Dany' forderte ihn auf, 'so schnell wie möglich zu mir zu kommen', was seiner Mutter zufolge der letzte Anstoß für seinen Suizid war.

Character.Ai verteidigte sich mit dem Verweis auf den Ersten Verfassungszusatz, der die Meinungsfreiheit schützt. Das Unternehmen argumentierte, dass dieser Zusatz auch für Chatbots gelte, wodurch es nicht für 'angeblich schädliche Aussagen, einschließlich solcher, die zum Suizid führen', haftbar gemacht werden könne.

Der Richter wies dieses Argument zurück und erklärte, sie sei 'derzeit nicht bereit', Chatbot-Ausgaben als geschützte Meinungsäußerungen einzustufen. Der Prozess kann fortgesetzt werden, was das erste Mal ist, dass ein Gericht entscheidet, ob ein KI-Unternehmen für schädliche KI-Inhalte verantwortlich gemacht werden kann.

Character.Ai argumentierte auch, dass Chatbot-Texte unter Abschnitt 230 des US-Telekommunikationsgesetzes von 1996 fallen, der Tech-Unternehmen in der Regel vor Haftung für nutzergenerierte Inhalte schützt. Das Unternehmen verglich Chatbots mit externen Plattformnutzern. Das Gericht muss diese Behauptung noch prüfen.

Setzer IIIs Mutter will auch Google zur Verantwortung ziehen, da der Tech-Riese mit Character.Ai zusammenarbeitet. Googles Lizenzvereinbarung mit dem KI-Unternehmen wird auf mögliche Kartellrechtsverstöße untersucht. Google bestreitet eine Beteiligung und behauptet, keine Anteile an Character.Ai zu halten.

Nederlands

Nederlands

English

English

Deutsch

Deutsch

Français

Français

Español

Español

Português

Português